Determinar la validez de constructo y la confiabilidad de un examen clínico objetivo estructurado (ECOE) en la evaluación de una certificación nacional como reumatólogo.

MétodoEn 2013 y 2014, se aplicaron sendos ECOE y evaluación teórica (ET) a 32 y 38 residentes aspirantes a la certificación de reumatólogo, respectivamente. Se incluyeron 12 y 15 estaciones calificadas mediante lista de cotejo validada. Previamente, 3 reumatólogos certificados realizaron sendas pruebas piloto. Se calculó la puntuación global del ECOE y se evaluó su desempeño.

ResultadosEn 2013, la media ± DE del ECOE fue de 7,1 ± 0,6) y ningún aspirante tuvo calificación reprobatoria (CR); la media de la ET fue de 6,5 ± 0,6 y 7 aspirantes (21,9%) tuvieron CR (< 6). En 2014, la media del ECOE fue de 6,7 ± 0,6) y 3 aspirantes (7,9%) tuvieron CR, de los cuales 2 reprobaron la ET; la media de la ET fue de 6,4 ± 0,5) y 7 aspirantes (18,5%) tuvieron CR, 2 de los cuales reprobaron el ECOE.

En 2013, la correlación entre el ECOE y la ET fue de r=0,44, p=0,006. En ambos años, los reumatólogos certificados obtuvieron mejores calificaciones en el ECOE que los residentes. El porcentaje de aprobados en la ET fue mayor entre quienes aprobaron el ECOE que entre quienes lo reprobaron: 86% vs. 67%, p=0,02.

Se aplicaron 9 estaciones en ambos años y sus puntuaciones mostraron correlación de 0,81 a 0,95, p ≤ 0,01.

ConclusiónEl ECOE es una herramienta adecuada para evaluar las competencias clínicas de los aspirantes a la certificación.

To assess reliability and validity of the objectively-structured clinical examination (OSCE) applied in postgraduate certification processes by the Mexican Board of Rheumatology.

MethodThirty-two (2013) and 38 (2014) Rheumatology trainees (RTs) underwent an OSCE consisting of 12 and 15 stations respectively, scored according to a validated check-list, as well as 300-multiple-choice 300 question examination (MCQ). Previously, 3 certified rheumatologists underwent a pilot-OSCE. A composite OSCE score was obtained for each participant and its performance examined.

ResultsIn 2013, OSCE mean score was 7.1±0.6 with none RT receiving a failing score while the MCQ score was 6.5±0.6 and 7 (21.9%) RTs receiving a failing (< 6) score. In 2014, the OSCE score was 6.7±0.6, with 3 (7.9%) RTs receiving a failing score (2 of them also failed MCQ) while the MCQ score was 6.4±0.5 and 7 (18.5%) RTs were disqualified (2 of them also failed OSCE). A significant correlation between the MCQ and the OSCE scores was observed in the 2013 (r=0.44; P=0.006). Certified rheumatologists performed better than RTs at both OSCE.

Overall, 86% of RTs obtaining an OSCE passing score also obtained a MCQ passing score, while this was only 67% (P=.02) among those who obtained an OSCE failing score.

Nine stations were applied at both consecutive years. Their performance was similar in both certification processes, with correlation coefficients ranging from 0.81 to 0.95 (P≤0.01).

ConclusionThe OSCE is a valid and reliable tool to assess the Rheumatology clinical skills in RTs.

Los Consejos de Especialidades Médicas son cuerpos colegiados formados por destacados profesionales de la Medicina que cultivan una misma disciplina y quienes establecen el proceso de certificación y certificación vigente. El Consejo Mexicano de Reumatología, A.C. (CMR) fue fundado el 10 de febrero de 1975. Actualmente, está formado por 12 consejeros. Desde su inicio, el CMR ha certificado a 730 reumatólogos de adultos y 49 reumatólogos pediatras mediante un examen, el cual consta de una parte teórica y de una práctica. Hasta el año 2012, la evaluación práctica fue llevada a cabo con un paciente real, en la modalidad de caso único.

El examen de certificación de cualquier especialidad médica se considera un examen de altas consecuencias, por lo que los Consejos deben de hacer lo posible porque las herramientas de evaluación se realicen en el marco conceptual técnico apropiado y con profesionalismo educativo1. El examen de caso real o caso único evalúa el desempeño médico en escenarios reales, verifica las capacidades del sustentante para obtener información útil, tomar decisiones apropiadas, integrar conocimientos previos y discutir puntos de vista. Sin embargo, es poco confiable y reproducible2. El examen clínico objetivo estructurado (ECOE) es un instrumento de evaluación altamente objetivo, que permite examinar competencias y un amplio número de habilidades por lo que algunos autores lo consideran el estándar de oro para evaluar las competencias clínicas3-6. Desde 1975, el ECOE ha sido usado en Canadá, Estados Unidos de Norteamérica, Australia y Europa para evaluar habilidades clínicas de pregrado. En México, se emplea desde 1996 como examen sumativo en la Facultad de Medicina de la Universidad Autónoma de México y como la fase práctica del examen profesional de la Licenciatura desde el año 20027. Además, el ECOE ha mostrado también buenos resultados para evaluar a médicos generales8, cirujanos9, pediatras10, reumatólogos11 y habilidades de ultrasonido músculo-esquelético12.

Desde sus orígenes, el CMR ha reconocido que la competencia clínica es un aspecto crucial del entrenamiento de todo futuro reumatólogo. Hace 2 años, el CMR implementó un ECOE para aplicarlo a los aspirantes, como parte de la certificación anual del CMR. El presente trabajo describe dicho proceso y examina la validez (de constructo) y la confiabilidad del ECOE.

Material y métodosPlaneación del examen clínico objetivo estructurado (fig. 1)En febrero del año 2012, el CMR implementó un plan de trabajo para desarrollar un ECOE, el cual sería aplicado por primera vez en enero del 2013, durante el examen para obtener la certificación como reumatólogo. Se integró un comité ECOE con 4 consejeros, quienes el 21 de mayo del año 2012 acreditaron un Curso-Taller de Evaluación de la Competencia con el Examen Clínico Objetivo Estructurado, impartido dentro del programa de formación de profesores por la Secretaría de Educación Médica de la UNAM.

A finales de mayo, el CMR elaboró una tabla de especificaciones y una matriz de competencias, utilizando los contenidos académicos del curso de Reumatología13 y considerando la prevalencia estimada en nuestro país de las enfermedades reumatológicas14. La propuesta final incluyó el diseño de 14 estaciones, con requisitos bien definidos7.

De manera paralela, se integraron 3 comités:

- –

Comité de validación de las estaciones. Se programó una sesión de 3 h, en la cual se definió el objetivo de la misma, se presentó el contenido de cada estación y se validó la lista de cotejo (acuerdo ≥ 80%). Se validaron 12 de las 14 estaciones.

- –

Comité de entrenamiento de pacientes, el cual seleccionó y entrenó a 18 pacientes.

- –

Comité de entrenamiento de los evaluadores. Se seleccionó a 7 consejeros y a 5 reumatólogos con más de 10 años de experiencia. Todos recibieron indicaciones sobre el papel y comportamiento de los evaluadores durante el ECOE.

La prueba piloto se llevó a cabo en diciembre del 2012, en las instalaciones de la Facultad de Medicina de la UNAM, construidas ex profeso. Se diseñó un circuito con las 12 estaciones previamente validadas, el cual fue realizado por 3 reumatólogos certificados con menos de 3 años de experiencia.

El 19 de enero del año 2013 se aplicó el primer ECOE como evaluación práctica del examen para obtener la certificación del CMR. El 20 de enero se aplicó el examen teórico. El examen del CMR correspondiente al siguiente año se llevó a cabo el 18 y 19 de enero del 2014, en sus versiones práctica (ECOE) y teórica, respectivamente. El diseño y la preparación del mismo fueron similares a lo descrito.

Diseño del examen clínico objetivo estructuradoEl circuito para la evaluación del año 2013 estuvo integrado por 12 estaciones para evaluar a los aspirantes y 4 estaciones de descanso; el circuito para el año 2014 se integró con 15 estaciones de evaluación y 5 estaciones de descanso. Todas las estaciones tuvieron una duración de 8 min. Las patologías abordadas en las estaciones fueron: síndrome de Sjögren, lumbalgia mecánica, esclerosis sistémica progresiva, artritis reumatoide, miopatía inflamatoria, gota, hombro doloroso, lupus eritematoso generalizado, síndrome de antifosfolípidos, espondiloartropatías seronegativas y osteoartritis.

Población a la cual se aplicaron el examen clínico objetivo estructurado y el examen teóricoLa primera versión del ECOE se aplicó a 32 aspirantes y la segunda a 38, quienes cumplían con los requisitos del CMR para sustentar el examen y habían cumplido su etapa de formación en Reumatología en las diferentes sedes del país reconocidas para tal efecto.

Prueba teórica del examen del ConsejoEl examen teórico consistió en un instrumento de 300 preguntas de opción múltiple, de las cuales 250 fueron casos clínicos integrados por 5 preguntas cada uno y 50 preguntas aisladas de diferentes temas de inmunología, en formato de opción múltiple.

Puntuación para la certificaciónSe calificaron las pruebas teórica y práctica de manera independiente.

Se calificó cada estación sumando los puntos obtenidos en la lista de cotejo y se llevó a una escala decimal. Posteriormente, se realizó una media aritmética considerando el valor de cada estación y se determinó la calificación global del ECOE.

En el año 2013 no se consideró ninguna puntuación mínima para acreditar el ECOE y se acreditó el examen del CMR cuando el promedio de ambas pruebas fue ≥ 6.

En el año 2014 se consideró un valor ≥ 6 para acreditar el ECOE (y el mismo valor para acreditar la prueba teórica).

Análisis estadísticoSe realizó estadística descriptiva y se usaron las pruebas adecuadas a la distribución de las variables.

Validez de constructo: se correlacionó la puntuación de la prueba escrita y la del ECOE mediante el coeficiente de correlación de Pearson. La correlación se evaluó con base en la calificación del examen teórico y la del ECOE global. Se dividieron los puntajes de la prueba teórica en cuartiles y se determinó la distribución de los aspirantes que tuvieron una calificación aprobatoria y no aprobatoria en los diferentes cuartiles y se realizó prueba de Wilcoxon. Finalmente, el puntaje de cada estación del ECOE se comparó entre aspirantes y reumatólogos certificados mediante la prueba t de Student (2 colas).

Para detectar redundancia potencial debido al uso de estaciones múltiples, se calculó la correlación interestación a partir del puntaje total del ECOE de cada participante y del puntaje de cada estación, usando la prueba de coeficientes de correlación de Pearson.

Los análisis se realizaron usando el paquete estadístico SPSS20.

ResultadosPuntuación del examen de certificación2013 (32 aspirantes): la puntuación general del ECOE en el grupo fue de (media±DE) 7,1±0,6; todos los aspirantes tuvieron una calificación ≥ 6. La puntuación general de la prueba teórica fue de 6,5±0,6; 25 aspirantes (78,1%) tuvieron una calificación ≥ 6.

2014 (38 aspirantes): la puntuación general del ECOE en el grupo fue de 6,7±0,6; 35 aspirantes (92,1%) tuvieron una calificación aprobatoria (≥ 6). De los 3 aspirantes que tuvieron una calificación no aprobatoria en el ECOE, 2 de ellos también tuvieron una calificación no aprobatoria en el teórico. La puntuación general de la prueba teórica fue de 6,4±0,5 y 31 aspirantes (81,6%) tuvieron una calificación aprobatoria (≥ 6). De los 7 aspirantes que reprobaron el teórico, 2 también reprobaron el ECOE. Finalmente, 30 aspirantes tuvieron una calificación aprobatoria en ambas pruebas (78,9%).

En el año 2013, las puntuaciones (media±DE) para cada estación variaron de 4,5±2,1 a 8,8±2,0 y en el año 2014 de 5,0±2,7 a 8,2±1,7. En el año 2013, el porcentaje de aspirantes con calificación ≥ 6 varió del 18,8 al 96,9%, dependiendo de la estación, mientras que en el año 2014 fue del 36,8 al 100% (tabla disponible en línea).

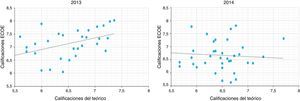

ValidezSe correlacionaron las calificaciones obtenidas por cada sustentante en el ECOE global y la calificación del examen teórico. En el año 2013, se encontró una correlación moderada (r=0,436) y significativa (p=0,006), mientras que en el año 2014 la correlación fue pobre y no significativa (r=0,203; p=NS) (fig. 2).

La validez del ECOE también se evaluó mediante el constructo de experiencia comparando las puntuaciones de los aspirantes con las de los reumatólogos certificados con 2 y 3 años de experiencia. Las puntuaciones obtenidas por estos últimos fueron significativamente mayores que las de los aspirantes en 8 de las 12 estaciones que conformaban el circuito del año 2013 y en 10 de las 15 estaciones que conformaban el circuito del año 2014 (tabla publicada en línea).

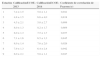

ConcordanciaSe dividieron los resultados del examen teórico en cuartiles y se determinó en cada cuartil, el número de aspirantes con calificación aprobatoria y no aprobatoria en el ECOE (únicamente durante el año 2014, ya que en el año 2013 ningún alumno reprobó el ECOE). Los resultados se presentan en la tabla 1. Se comparó el porcentaje de aprobados en la ET entre los aspirantes que reprobaron el ECOE y los que tuvieron una calificación aprobatoria del ECOE: 67% vs. 86%, p=0,02 (chi al cuadrada). Finalmente, se apreció la misma tendencia cuando se compararon las calificaciones de la prueba teórica; el promedio de la anterior en los 3 aspirantes que reprobaron el ECOE fue menor que en los 35 aspirantes que tuvieron una calificación aprobatoria: 5,9±0,6 vs. 6,5±0,45, p=0,2 (prueba de Wilcoxon).

Confiabilidad-reproducibilidadSe comparó el desempeño del grupo de aspirantes-2013 (N=32) y el de aspirantes-2014 (N=38) de las 9 estaciones que se repitieron en ambos años. Los datos faltantes debido a la diferencia de aspirantes entre ambos años se asignaron de acuerdo con el promedio del grupo. Las correlaciones entre las puntuaciones obtenidas en ambos ECOE fueron buenas y mostraron valores de r>0,8 y p ≤ 0,01 (tabla 2).

Comparación de las puntuaciones de las estaciones aplicadas en el examen clínico objetivo estructurado 2013 y examen clínico objetivo estructurado 2014 (p≤0,01)

| Estación | CalificaciónECOE-2013 | CalificaciónECOE-2014 | Coeficiente de correlación de Pearson (r) |

|---|---|---|---|

| 1 | 7,4±1,5 | 5,8±1,1 | 0,941 |

| 2 | 4,8±1,5 | 6,6±4,0 | 0,818 |

| 3 | 4,5±2,1 | 5,0±2,7 | 0,809 |

| 4 | 8,0±1,3 | 8,2±1,7 | 0,869 |

| 5 | 8,0±1,3 | 7,5±1,7 | 0,937 |

| 6 | 7,1±1,6 | 6,5±1,3 | 0,845 |

| 7 | 8,0±1,4 | 7,6±2,0 | 0,926 |

| 8 | 7,9±1,3 | 6,4±2,4 | 0,942 |

| 9 | 8,0±2,1 | 5,8±1,1 | 0,947 |

La alfa de Cronbach de los reumatólogos certificados que realizaron la prueba piloto en ambos años (considerando las 9 estaciones repetidas fue de 0,83 a 0,92).

Finalmente, la correlación media interestación (comparación de la puntuación de cada estación dentro de cada participante) fue baja en ambos años: r=0,17, rango= –0,11 a 0,35 para el año 2013 y r=0,18, rango de –0,20 a 0,57 para el año 2014.

DiscusiónEl trabajo describe el diseño, el desarrollo y la aplicación de un ECOE para evaluar las habilidades clínicas en el examen de Certificación anual de Reumatología aplicado por el CMR. En años recientes, se ha propuesto que el ECOE es una herramienta más objetiva para evaluar las competencias clínicas, especialmente cuando se compara con otras modalidades, como el caso clínico único. Sin embargo, se reconocen sus limitaciones, por lo que debe de ser sometido a un riguroso escrutinio y a una prueba piloto como un paso previo a su aplicación3.

El ECOE fue diseñado por un grupo colegiado de expertos, quienes aplicaron las recomendaciones internacionales para su desarrollo15, entre las cuales cabe resaltar el establecimiento previo de una tabla de especificaciones, la validación de las estaciones por un grupo de expertos y la aplicación de una prueba piloto. La evaluación del ECOE se realizó con referencia a criterio, ya que se fijó de antemano un estándar, como lo recomienda la tendencia actual de la educación basada en competencias (www.conacem.org).

La validez de constructo del ECOE fue analizada de varias maneras. Por una parte, se correlacionó el desempeño del ECOE con el de la parte teórica del examen de certificación. En la literatura se han descrito correlaciones significativas entre el ECOE y las evaluaciones teóricas con valores que oscilan entre 0,59 y 0,7116-18, si bien existe escasa información en el ámbito reumatológico11,12; un reporte reciente publicado por Kissin et al. describen una correlación de 0,52 (p ≤ 0,001) entre un circuito de n9 estaciones diseñado para evaluar habilidades de ultrasonido musculo-esquelético y su correspondiente parte teórica12; por el contrario, Raj et al. no encontraron una correlación significativa entre los conocimientos teórico y práctico, cuando este último se evaluó mediante 2 estaciones de exploración de mano y rodilla y se aplicó a estudiantes de medicina19. Encontramos una correlación de 0,44 en el año 2013, mientras que no hubo correlación en el año 2014. Lo anterior pudiera estar relacionado a un peor desempeño de los aspirantes en la prueba teórica en el año 2014 y/o por el hecho de que ambas evaluaciones (teórica y práctica) midieron diferente conocimiento. Cabe resaltar que el encontrar una alta correlación entre las 2 evaluaciones indica que se obtiene únicamente una pequeña ganancia de información relativa al conocimiento del aspirante, cuando se aplican ambos instrumentos; una hipótesis plausible es que en situaciones de alta correlación entre ambos, el ECOE explora (al igual que la prueba teórica) «el saber» y el «saber cómo» y se aleja del «demuestra cómo» de la pirámide de Miller20. En relación con este punto, Matsell et al.10 identificaron un elemente clave en la validez de constructo de un ECOE cuando se establece sobre la base de la alta correlación con una evaluación escrita. Desde un punto de vista teórico, el ECOE evalúa una amplia variedad de habilidades/competencias clínicas, por lo que los autores proponen categorizar las estaciones en 4 grandes dominios (conocimiento, solución de problemas, habilidades clínicas y manejo del paciente) y correlacionar las estaciones de cada dominio con la parte teórica correspondiente. Esta propuesta, que tiene un gran fundamento teórico será incluida, en la próxima aplicación del ECOE.

Con respecto a la validez de constructo, también se analizó con el constructo de experiencia; una evaluación válida debiera de mostrar cómo los aspirantes con mayor experiencia tienen mejor desempeño21. Todos los aspirantes tenían una formación similar en años. Sin embargo, el mismo circuito se aplicó a 3 reumatólogos recién certificados, en condiciones similares a las del día del examen. En general, los últimos tuvieron mejores puntuaciones que los aspirantes.

Finalmente, y de manera indirecta, la validez de constructo se analizó en el año 2014 comparando el porcentaje de aprobados en la prueba teórica (y la media de la calificación) en quienes aprobaron o no el ECOE. Nuestros resultados apoyan la validez del instrumento.

Con respecto a la confiabilidad, no se realizó una evaluación de la anterior como tal si bien se han propuesto 3 maneras de aumentar la confiabilidad del ECOE y todas ellas fueron implementadas: diseño de estaciones de corta duración para permitir la evaluación de múltiples situaciones clínicas, evaluación de las estaciones a través de listas de cotejo predeterminadas y la integración de los circuitos con diferentes estaciones, evaluadores y pacientes simulados17. En nuestro caso, los pacientes seleccionados fueron pacientes reales (salvo 2 actores); no obstante, recibieron entrenamiento con libretos diseñados para representar la patología de cada estación y revisados por un grupo de expertos. Todo lo anterior incrementa la confiabilidad del ECOE sin afectar a su validez, como cuando se usan pacientes simulados o actores. Además, 9 de las estaciones se aplicaron en los 2 años consecutivos y mostraron una excelente estabilidad entre los 2 grupos de aspirantes y la consistencia interna entre los reumatólogos certificados en la prueba piloto fue excelente. Finalmente, si bien se encontró una baja correlación interestación, indica que cada estación evaluó habilidades o competencias diferentes y, por tanto, descarta redundancia de nuestro instrumento. Es importante recalcar la necesidad de incluir un número adecuado de estaciones para no afectar la confiabilidad del ECOE3,22. En el único (que tengamos conocimiento) ejercicio similar en nuestra especialidad el circuito estuvo constituido por 12 estaciones11.

Probablemente, uno de los mayores beneficios de un ECOE (y de otras evaluaciones similares) es la posibilidad de identificar deficiencias en la formación de los residentes y, eventualmente, modificar el currículo. Para ello es imprescindible contar con una herramienta de evaluación óptima. Si bien es cierto que el desempeño de nuestro instrumento fue adecuado, no debemos olvidar que el ECOE es finalmente una aproximación a los problemas reales pero no un encuentro médico-paciente real. Nuestra experiencia se limita a 2 años, mientras que se recomienda que todo instrumento sea utilizado por 3 a 5 años consecutivos, lo que permite una adecuada calibración del mismo. Además, el ECOE no se reprodujo en su totalidad en los años consecutivos. Con respecto a la evaluación de las estaciones, no se aplicó ningún método científico para establecer la puntuación aprobatoria para cada estación23, sino que se establecieron unos criterios previos. El ECOE aplicado a los reumatólogos certificados (prueba piloto) se desarrolló en un día diferente del ECOE aplicado a los aspirantes, si bien se realizó un esfuerzo por reproducir las condiciones de la evaluación final. La implementación del ECOE requirió de recursos financieros y humanos; realizamos el ejercicio de definir los costos y estos ascendieron a 120.000 pesos (alrededor de 9.200 dólares), cifra que no es excesiva pero sí mucho mayor a lo habitualmente invertido en la evaluación práctica de los residentes y pudiera afectar a su factibilidad a largo plazo.

En conclusión, el ECOE diseñado por el CMR mostró adecuadas validez de constructo y confiabilidad, por lo cual puede ser integrado como un instrumento de evaluación de las competencias clínicas en el examen de Certificación como reumatólogo. Los Consejos de Certificación tienen la responsabilidad social y ante la comunidad médica de documentar que un especialista es competente para ejercer su práctica. Es por ello necesario que incorporen rigor, calidad metodológica y trasparencia a sus procesos de certificación. De manera paralela, la sociedad debe de exigirles una mayor profesionalización. El esfuerzo conjunto de la sociedad, la comunidad médica, los pacientes y las autoridades competentes debe de tener un objetivo común, contribuir a incrementar la calidad de la atención médica que recibe nuestra población.

Responsabilidades éticasProtección de personas y animalesLos autores declaran que para esta investigación no se han realizado experimentos en seres humanos ni en animales.

Confidencialidad de los datosLos autores declaran que en este artículo no aparecen datos de pacientes.

Derecho a la privacidad y consentimiento informadoLos autores declaran que en este artículo no aparecen datos de pacientes.

Conflicto de interesesLos autores declaran no tener ningún conflicto de intereses.